Últimas Notícias

Cartão de crédito aprovando geral – Confira

O cartão de crédito para diaristas pode parecer algo distante, mas na realidade essas profissionais estão em busca de opções que lhes proporcionem uma melhor organização financeira. Afinal, esses cartões permitem o pagamento parcelado...

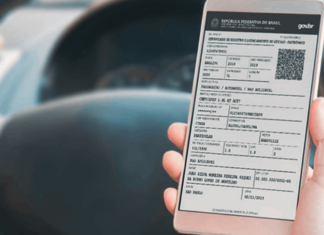

Documento de veículo online: Como emitir e obter de maneira rápida

A tecnologia está presente na vida de todos os brasileiros de alguma forma, trazendo praticidade e agilidade. Um exemplo disso é a facilidade de mostrar o documento do veículo para um guarda de trânsito...

Supermercados Continente: Dicas para conquistar vagas de emprego

Seja para conseguir o primeiro emprego ou para alavancar a carreira, o Continente Supermercados é sempre uma ótima opção para quem busca trabalho em Portugal. Especialmente após ter sido adquirido pelo grupo Sonae, uma...

Cartão da rede de supermercados Pingo Doce – Como solicitar

A rede de supermercados Pingo Doce é amplamente reconhecida em todo o território português, como você já deve saber. No entanto, você já considerou a possibilidade de obter um cartão gratuito que oferece acumulação...

Banco Digital da Ambev: Descubra como funciona e aproveite os benefícios

O BEES Bank é a solução digital da Ambev para ajudar micro, pequenos e médios empresários a gerirem suas finanças. A ideia surgiu devido à falta de praticidade e acesso à informação do financeiro...

Cartão Lidl: Como solicitar e aproveitar os benefícios exclusivos

O cartão Lidl é uma opção digital que representa os investimentos dessa marca de supermercado em tecnologia. Por meio de um aplicativo de celular grátis para baixar, os clientes podem acessar cupons de desconto...